採用AIの「見えないリスク」をどう管理するか―米国で急拡大するAIガバナンスプラットフォーム「3つの類型」

テクノロジーの進化に伴い、履歴書の解析や動画面接、スクリーニングなど、採用プロセスにAIを活用する企業が増えている。

一方で人事の現場では、AIがどのような基準で候補者を評価しているのか不明瞭なままツールを使用しているケースも少なくない。「AIの判断に差別はないのか」「説明責任を果たせるのか」「海外の法規制に対応できているのか」といった新たな懸念が広がっている。

Warden AIの調査報告書「State of AI Bias in Talent Acquisition 2025」によると、AI導入を検討するHRリーダーの75%が「バイアスや公平性」を主要な懸念として挙げており、これは「データプライバシーおよびセキュリティ(50%)」を上回る結果となった(※1)。

採用AIを巡る焦点は、もはや「どのツールを、どう使うか」ではなく、「見えないリスクをどう管理するか」へと移行しつつある。

AIが招く「見えない差別」と法的リスク

採用AIがもたらすリスクは、単なる技術的な問題にとどまらない。学習データの偏りに起因する不公平な評価、判断理由を説明できないブラックボックス化、過剰な個人情報の収集や管理不備による漏えいなど、人事の判断や企業の信頼に直結する問題へと拡大している。こうしたリスクは、AIの性能が高まるほど不可視化され、企業が気づかないまま蓄積されていく。

実際、米国では採用AIを巡る法的トラブルが顕在化している。2023年、大手人事管理システムのWorkdayに対して提起された集団訴訟では、同社のアルゴリズムが人種、年齢、障害を理由に応募者を書類選考段階で不当に排除したと主張された(※2)。司法判断は係争中だが、連邦裁判所はWorkdayへ 顧客企業名のリストを開示するよう命じている。さらに2025年には、AI搭載のATS(iCIMS)を利用していたSirius XM Radioが、郵便番号や出身大学名などの代理変数を通じて人種差別を行ったとして訴訟の対象となった。

これらの訴訟はいずれも、AIツールの提供者だけでなく、利用企業自身が事後的に責任を問われた事例であり、米国の既存の連邦レベルの差別禁止法(公民権法、年齢差別禁止法など)を根拠に争われている点に留意が必要である(※3)。

「パッチワーク」から「包括規制」へ進む米国の法規制

既存の法律に加え、米国では透明性・説明責任・バイアス是正を重視する規制が州や都市レベルで急速に拡大している。

各規制は重視する側面が異なり、企業は地域ごとの義務に対応しなければならない。特に注意すべきは、規制が「その州に本社がある企業」だけでなく、「その州で勤務する候補者を採用するすべての企業」に適用される点である。たとえば、カリフォルニア州に本社を置く企業が、ニューヨーク市やイリノイ州在住の応募者をリモート勤務で採用する場合、それぞれの地域の規制を遵守する必要がある。

採用AIに関する主な米国の規制

| 地域 (施行年) |

規制対象技術 | 規制対象者 | 企業の主な義務 | 主な焦点 |

| イリノイ州 (2020年) |

AI動画面接 録画された面接動画に対し、アルゴリズムを用いて評価・分析するもの。 |

利用企業 | ①AI分析の事前通知と説明、②応募者の同意取得、③専門家以外への動画の共有禁止、④応募者の要求後30日以内のデータ削除 | 透明性・説明責任・データ管理 |

| メリーランド州 (2020年) |

顔認識技術 面接等での顔の特徴データ(テンプレート)を作成するもの。 |

利用企業 | ①顔認識の利用を原則禁止(同意がある場合を除く)、②応募者から書面による署名付き同意(権利放棄書)を取得 | プライバシー保護・生体データの管理権 |

| ニューヨーク市 (2023年) |

自動雇用決定ツール(AEDT) 雇用や昇進の判断に利用され、職務適合性等をスコアリングするツール。 |

利用企業、職業紹介会社 | ①第三者機関による年次バイアス監査(性別・人種等の考査分析)の実施、②自社サイトでの監査結果公表、③応募者への事前通知 | バイアス監査・公平性 |

| コロラド州 (2026年6月施行予定) |

高リスクAIシステム 雇用、教育、金融、医療など、個人の人生に重大な影響を与えるAI。 |

開発企業、利用企業 | ①アルゴリズム差別を防ぐ「合理的注意」義務、②リスク管理プログラムの策定、③誤ったデータに対する訂正や再審査請求の機会提供 | アルゴリズム差別禁止・消費者保護・包括的ガバナンス |

出所:資料(※4)を基に筆者作成

州レベルの規制における新たな潮流として、従来の「特定のツール(面接や顔認識)」を対象とした規制から、より広範な「分野横断的な規制」へのシフトが見られる。これを象徴するのが、2026年6月に施行予定のコロラド州AI法である。

同法は、開発企業・利用企業の双方に対し、差別が起きないよう設計から運用に至る厳格なリスク管理体制を義務づけている。

加えて、AI管理体制の国際規格「ISO/IEC 42001」も制定されており、AIの公平性や透明性を企業としてどう管理するかが問われる段階に入っている。

海外で拡大するAIガバナンスプラットフォーム3類型

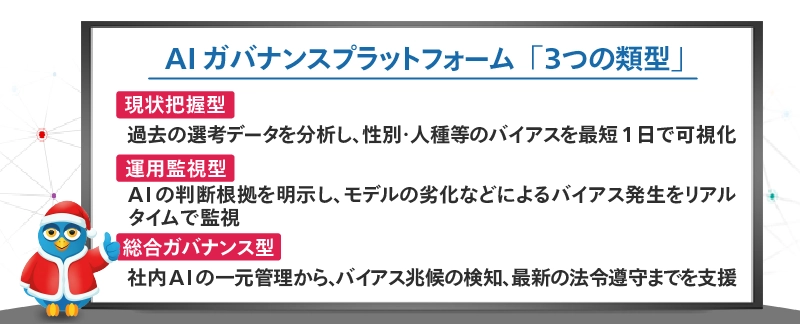

2024年のEU AI規制法成立など、法規制や国際規格は年々複雑化しており、人事部門だけですべてを把握し、対応するには限界がある。こうした背景から、企業のリスク管理を支援する「AIガバナンスプラットフォーム」が急成長している。主要なサービスは下記の3つの類型に整理できる。

1. 現状把握型

過去の応募者データや選考結果を基に、採用プロセスに偏りがないかをセルフチェックするプラットフォーム。本格的なガバナンス体制構築の前に、まず現状を把握したい企業に適した初期ステップである。

【代表サービス】FairCheck.ai、QuantPi

【主な機能】

・属性別(性別・年齢・人種など)の統計分析

・4/5ルール(米国基準のバイアス判定)に基づく検出

・合格率やスコア差を可視化するダッシュボード

・数時間〜1日程度でのレポート自動生成

2. 運用監視型

AI導入後の運用フェーズにおいて、モデルの内部を深く監視し、「なぜその判断をしたのか(説明可能性)」や「暴走していないか」をリアルタイムで可視化・制御する。

自社開発企業や、HRテックベンダーが、モデルの品質維持のために利用するケースが多い。

学習データの劣化や環境変化による「採用差別」や「誤回答」を即座に検知し、事故を未然に防ぐ。

【代表サービス】Fiddler AI、Arthur AI、Aporia

【主な機能】

・データドリフト検知:過去の学習データが現在通用しなくなっている状態を技術的に検出

・リアルタイム監視:特定の属性を不利に扱い始めていないかの常時モニタリング

・不合格理由の可視化(XAI):判断根拠を明示し、ブラックボックス化を解消

・誤回答の阻止:チャットボット等の不適切な発言を検知・ブロック

3. 総合ガバナンス型

社内に点在するAIツールを一元管理し、バイアス評価、リスク判定、法規制対応、監査証跡の整備までを包括的に支援する。人事部門は、自社のAIがどの法律・規格の対象となり、遵守できているかを横断的に把握可能となる。

【代表サービス】FairNow、Holistic AI、Credo AI、Warden AI、Enzai.ai

【主な機能】

・社内AIツールの可視化(未許可の「シャドーAI」検知を含む)

・バイアス兆候の早期検知とアラート

・法的保護属性(人種・性別等)に基づく継続的な差別検知

・法規制や国際規格の変更に伴う影響把握と改善提案

・監査レポートや証跡の自動作成

企業の人事は、導入予定の採用AIツールやベンダーが、こうしたプラットフォームを活用してリスク管理を行っているかを確認することが、自社を守る第一歩となる。

また、さらに厳格なガバナンスを求める場合は、ORCAA(O'Neil Risk Consulting & Algorithmic Auditing)やBABL AIのような専門家による「人的監査」サービスも有効な選択肢である。

ツールやベンダー任せにしない「主体的なガバナンス」へ

2025年は、米国のほか、カナダ、中国、韓国など主要国でもAI関連法の施行が相次ぎ、AIガバナンス対応の重要性が一段と高まった。日本でも「AI事業者ガイドライン(第1.1版)」で、採用AIの公平性や説明責任が明記されたほか、「人工知能の関連技術の研究開発及び活用の推進に関する法律」(2025年9月全面施行)により、不適切なAIの開発や活用に対して国が指導や助言、情報提供などを行うこととなった(※5)。利用者である企業側も責任が問われる段階に入ったといえる。

重要なのは、AIガバナンスツールを導入すれば責任が免除されるわけではないという点である。プラットフォームは、あくまでリスクを検知する「センサー」にすぎない。問題発覚時にどう判断し、修正するか。そしてそのAIを使い続けるか否か。最終的な意思決定と責任は、AIを利用する企業自身にある。

リクルートワークス研究所が2025年に実施した米国大手企業の採用責任者へのインタビュー調査では、企業が自主的に「AIツールの内部監査」「学習データの制限(人種・性別等の除外)」「定期的なバイアス検証」を進めていることが明らかとなった。

日本でも「AIによる採用面接・人事評価サービス協議会(AIAC)」によるガイドライン策定や認証制度など、自主規制の動きが本格化している。

AIガバナンスは待ったなしの状況にある。企業はリスク管理をベンダー任せにするのではなく、「なぜこの候補者を合格にしたのか」を自ら説明できる体制を整えなければならない。 AI時代において、公平性と透明性を企業側が主体的に担保する姿勢こそが、求職者に選ばれ、社会から信頼されるための必須条件となるだろう。

TEXT=杉田真樹

(※1)https://warden-ai.com/state-of-ai-bias-in-talent-acquisition

(※2)https://www.hrdive.com/news/workday-must-supply-list-of-employers-who-enabled-hiredscore-ai/756506/

(※3)https://www.warden-ai.com/resources/harper-vs-siriusxm-the-growing-legal-risk-of-ai-in-hiring

(※4)https://www.ilga.gov/Legislation/publicacts/view/101-0260、https://mgaleg.maryland.gov/2020RS/chapters_noln/Ch_446_hb1202T.pdf、https://www.nyc.gov/assets/dca/downloads/pdf/about/DCWP-AEDT-FAQ.pdf、https://leg.colorado.gov/bills/sb24-205

(※5)https://laws.e-gov.go.jp/law/507AC0000000053

メールマガジン登録

メールマガジン登録 各種お問い合わせ

各種お問い合わせ