AI のお手並み拝見

力触覚

ロボットはケーキをつぶさずに持てるのか

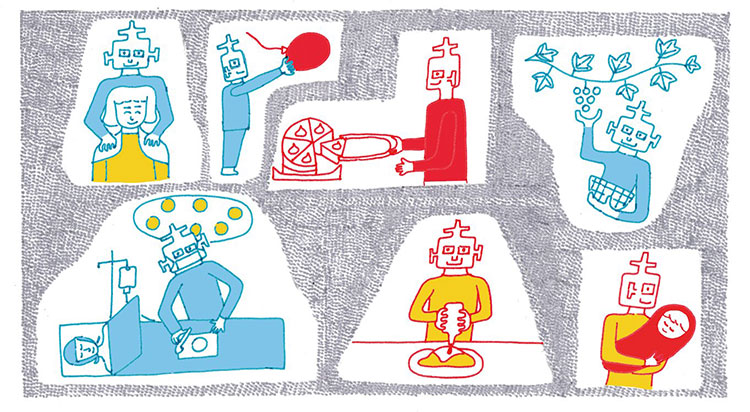

労働力不足が叫ばれる介護や医療、農業などの現場で、ロボットの活用が期待されている。これまでのロボットは産業用が主流で、ほとんどが工場のなかで使われてきた。最近は、人間の近くで協働するロボットに注目が集まっているが、そこにはまだまだ課題が多いといわれる。

その1つが、ロボットには「力触覚(りきしょっかく)」がないという点だ。

「力触覚とは、物に触れたときの手応えの感覚のことです。人間が、ポテトチップスを割らずにつかめるのも、ケーキをつぶさずに持てるのも、力触覚に応じて、瞬時に力加減を調整しているからです」

モーションリブCOOの緒方仁是氏はそう語る。同社は、機械に力触覚を与える制御技術「リアルハプティクス」の実用化を手掛けている。

これまでのロボットは、工場のような限られた場所で正確に位置を固定したうえで、極めて大きな力を出したり、一定の出力で作業を続けたりするのは得意だったが、物の形状や硬さに応じて、繊細な作業をするのは苦手だった。

「たとえば、ロボットアームが誤って人の腕をつかんだとき、とっさに力をゆるめるようなことはできません。人間のようには、微妙な力加減をコントロールできないのです」

これでは、人との接触の多い現場や、繊細な作業が求められる現場で、ロボットを活用することは難しい。より人間の身近で、安全に動くロボットを作るには、力触覚に応じて力を制御する技術が必要になる。

人が物に触った感覚をデータ化して機械に伝える

モーションリブの保有するリアルハプティクスは、機械の力加減を制御する技術の1つだ。もともとは慶應義塾大学が開発し、その後40年以上にわたって多くの研究者が携わり、磨かれてきた技術だという。

「一言でいうと、力触覚をデータ化できる技術です。ロボットを動かすモーター部分に、リアルハプティクスを搭載したチップを取り付けておきます。物に触れたときのモーターの動きの変化をもとに独自の計算を行い、“硬さ”の情報としてデータ化するという仕組みです」

触った感覚をデータ化することによって、その情報を伝送したり、同じ動きを再現させることが可能になる。たとえばロボットアームにチップを取り付けておくと、ロボットアームが物に触れた感覚を、操作する人間に伝えられる。その感触に応じて、人間が物をつかむ力を調整すれば、その力加減をロボットアームに伝えることができる。つまり人間は、実際に物に触った感覚を得ながら、ロボットアームを操作できるということだ。

「画像データなどと比べて、力触覚データは非常に軽い。ワイヤレスでデータを伝送し、離れた場所からロボットアームを操作することも可能です。また、そうした操作のデータをロボットアームに覚えさせれば、いつでもそれを簡単に再現することができます」

力触覚を得ることでロボットはより身近になる

こうした技術の登場により、ロボットがやさしい触り方を獲得すると、人でなければ難しかった作業も任せられるようになるはずだ。

実際、農業の現場ではロボットを導入して、傷を付けないように果物を荷詰めしたり、腐って出荷できないものを取り除いたり、大きさに応じて分類するようなシステムも、実用化されつつある。

さらには、外科手術のような極めて繊細な作業もロボットが担えるようになるかもしれない。

「現在実用化されている手術支援ロボットは、医師がモニターで患部を確認しながら、自分の手の動きをロボットに伝える仕組みになっています。それが、実際に触った感覚を医師にフィードバックできると、より安全で精度の高い手術が実現します。データ化された力触覚を増幅することもできるので、医師がより繊細な感覚を得て、これまで人の手では難しかった細かな施術が可能になるかもしれません」

柔らかい物を、壊れないようにそっとつかむ。人間にとって当たり前の能力を手に入れたとき、ロボットはより身近な存在になるだろう。

Text=瀬戸友子 Photo=平山諭 Illustration=山下アキ

緒方仁是氏

モーションリブ取締役COO

Ogata Masayoshi 慶應義塾大学大学院理工学研究科修了。在学中は、同期の飯田亘氏(同社取締役CTO)らと、大西公平教授の研究室でリアルハプティクスの研究に従事。卒業後は、金融系ITコンサルタントとして活躍していたが、2018年、リアルハプティクスの社会実装を目指すモーションリブに移り、COO に就任。

メールマガジン登録

メールマガジン登録 各種お問い合わせ

各種お問い合わせ